Streams stellen je in staat om data stuk voor stuk te lezen of te schrijven, zonder dat je de hele dataset in het geheugen hoeft te laden. Dit is enorm handig wanneer je met big data of real-time informatie werkt.

Maar waarom zou je je daar druk om maken? Stel je voor dat je de volgende Netflix bouwt. Je wilt dat gebruikers direct video's kunnen kijken, zonder te wachten tot het hele bestand is gedownload. Hier komen streams van pas. Ze laten je data in kleinere stukken verwerken, waardoor je app efficiënter en responsiever wordt.

Soorten Streams: Kies Je Strijder

Node.js biedt vier soorten streams, elk met zijn eigen superkracht:

- Readable: Voor het lezen van data. Zie het als de ogen van je app.

- Writable: Voor het schrijven van data. Dit is de pen van je app.

- Duplex: Kan zowel lezen als schrijven. Het is alsof je ogen en een pen tegelijk hebt.

- Transform: Een speciaal type Duplex stream dat data kan wijzigen terwijl het wordt overgedragen. Zie het als de hersenen van je app, die informatie direct verwerken.

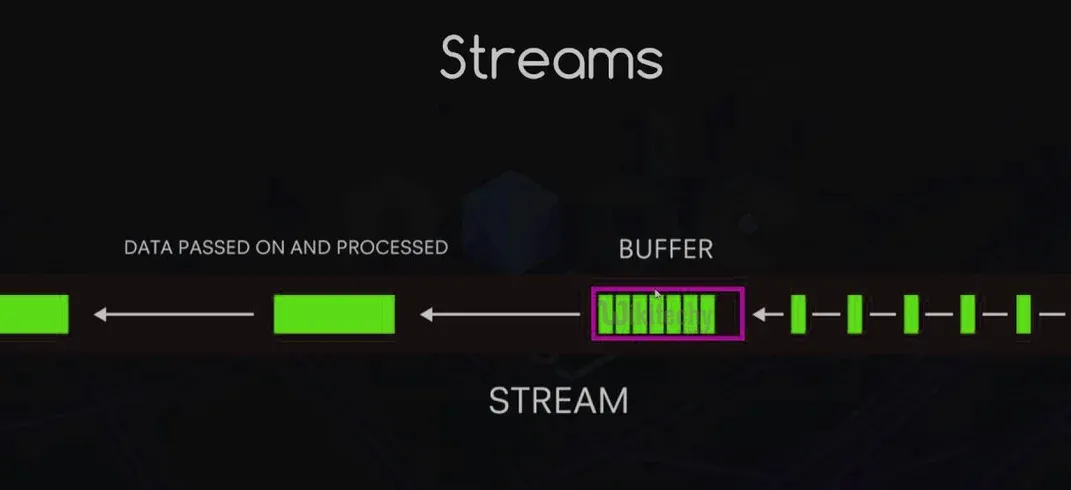

Hoe Streams Werken: De Basis van Datastroom

Stel je een lopende band in een fabriek voor. Datastukken bewegen langs deze band en worden één voor één verwerkt. Dat is in wezen hoe streams werken. Ze zenden gebeurtenissen uit terwijl data door hen stroomt, waardoor je op verschillende delen van het proces kunt inhaken.

Hier is een kort overzicht van de belangrijkste gebeurtenissen:

data: Wordt uitgezonden wanneer er data beschikbaar is om te lezen.end: Geeft aan dat alle data is gelezen.error: Houston, we hebben een probleem!finish: Alle data is naar het onderliggende systeem doorgesluisd.

Voordelen van het Gebruik van Streams: Waarom Je Moet Instappen

Het gebruik van streams is niet alleen om cool te zijn (hoewel het je er wel geweldig uit laat zien). Hier zijn enkele solide redenen om ze te gebruiken:

- Geheugenefficiëntie: Verwerk grote hoeveelheden data zonder al je RAM te gebruiken.

- Tijdefficiëntie: Begin direct met het verwerken van data, wacht niet tot alles is geladen.

- Composability: Koppel streams eenvoudig aan elkaar om krachtige datapijplijnen te creëren.

- Ingebouwde Backpressure: Beheer automatisch de snelheid van de datastroom om te voorkomen dat de bestemming wordt overweldigd.

Implementeren van Readable en Writable Streams: Code Tijd!

Laten we aan de slag gaan met wat code. Eerst maken we een eenvoudige leesbare stream:

const { Readable } = require('stream');

class CounterStream extends Readable {

constructor(max) {

super();

this.max = max;

this.index = 1;

}

_read() {

const i = this.index++;

if (i > this.max) {

this.push(null);

} else {

const str = String(i);

const buf = Buffer.from(str, 'ascii');

this.push(buf);

}

}

}

const counter = new CounterStream(5);

counter.on('data', (chunk) => console.log(chunk.toString()));

counter.on('end', () => console.log('Finished counting!'));

Deze leesbare stream telt van 1 tot 5. Nu maken we een schrijfbare stream die onze nummers verdubbelt:

const { Writable } = require('stream');

class DoubleStream extends Writable {

_write(chunk, encoding, callback) {

console.log(Number(chunk.toString()) * 2);

callback();

}

}

const doubler = new DoubleStream();

counter.pipe(doubler);

Voer dit uit en je ziet de nummers 2, 4, 6, 8, 10 verschijnen. Magie!

Werken met Duplex en Transform Streams: Twee-richtingsverkeer

Duplex streams zijn als een telefoongesprek - data kan beide kanten op stromen. Hier is een eenvoudig voorbeeld:

const { Duplex } = require('stream');

class DuplexStream extends Duplex {

constructor(options) {

super(options);

this.data = ['a', 'b', 'c', 'd'];

}

_read(size) {

if (this.data.length) {

this.push(this.data.shift());

} else {

this.push(null);

}

}

_write(chunk, encoding, callback) {

console.log(chunk.toString().toUpperCase());

callback();

}

}

const duplex = new DuplexStream();

duplex.on('data', (chunk) => console.log('Read:', chunk.toString()));

duplex.write('1');

duplex.write('2');

duplex.write('3');

Transform streams zijn als Duplex streams met een ingebouwde processor. Hier is er een die kleine letters omzet in hoofdletters:

const { Transform } = require('stream');

class UppercaseTransform extends Transform {

_transform(chunk, encoding, callback) {

this.push(chunk.toString().toUpperCase());

callback();

}

}

const upperCaser = new UppercaseTransform();

process.stdin.pipe(upperCaser).pipe(process.stdout);

Probeer dit uit te voeren en typ wat tekst in kleine letters. Zie hoe het magisch in hoofdletters verandert!

Omgaan met Stream Gebeurtenissen: Alle Actie Vangen

Streams zenden verschillende gebeurtenissen uit die je kunt beluisteren en afhandelen. Hier is een kort overzicht:

const fs = require('fs');

const readStream = fs.createReadStream('hugefile.txt');

readStream.on('data', (chunk) => {

console.log(`Received ${chunk.length} bytes of data.`);

});

readStream.on('end', () => {

console.log('Finished reading the file.');

});

readStream.on('error', (err) => {

console.error('Oh no, something went wrong!', err);

});

readStream.on('close', () => {

console.log('Stream has been closed.');

});

Stream Pipelines: Bouw Je Data Snelweg

Pipelines maken het eenvoudig om streams aan elkaar te koppelen. Het is als het bouwen van een Rube Goldberg-machine, maar dan voor data! Hier is een voorbeeld:

const { pipeline } = require('stream');

const fs = require('fs');

const zlib = require('zlib');

pipeline(

fs.createReadStream('input.txt'),

zlib.createGzip(),

fs.createWriteStream('input.txt.gz'),

(err) => {

if (err) {

console.error('Pipeline failed', err);

} else {

console.log('Pipeline succeeded');

}

}

);

Deze pipeline leest een bestand, comprimeert het en schrijft de gecomprimeerde data naar een nieuw bestand. Alles in één soepele operatie!

Buffering vs. Streaming: De Confrontatie

Stel je voor dat je bij een all-you-can-eat buffet bent. Buffering is als je hele bord vullen voordat je gaat eten, terwijl streaming is als het nemen van één hap tegelijk. Hier is wanneer je elk moet gebruiken:

- Gebruik Buffering Wanneer:

- De dataset klein is

- Je willekeurige toegang tot de data nodig hebt

- Je bewerkingen uitvoert die de hele dataset vereisen

- Gebruik Streaming Wanneer:

- Je met grote datasets werkt

- Je real-time data verwerkt

- Je schaalbare en geheugenefficiënte applicaties bouwt

Backpressure Beheren: Laat Je Pijpen Niet Barsten!

Backpressure is wat er gebeurt wanneer data sneller binnenkomt dan het kan worden verwerkt. Het is als proberen een gallon water in een pintglas te gieten - dingen worden rommelig. Node.js streams hebben ingebouwde backpressure-afhandeling, maar je kunt het ook handmatig beheren:

const writable = getWritableStreamSomehow();

const readable = getReadableStreamSomehow();

readable.on('data', (chunk) => {

if (!writable.write(chunk)) {

readable.pause();

}

});

writable.on('drain', () => {

readable.resume();

});

Deze code pauzeert de leesbare stream wanneer de buffer van de schrijfbare stream vol is, en hervat deze wanneer de buffer is geleegd.

Toepassingen in de Praktijk: Streams in Actie

Streams zijn niet alleen een coole truc. Ze worden voortdurend in echte toepassingen gebruikt. Hier zijn een paar voorbeelden:

- Bestandsverwerking: Lezen en schrijven van grote logbestanden

- Media Streaming: Video- en audiocontent serveren

- Data Import/Export: Verwerken van grote CSV-bestanden

- Real-time Data Verwerking: Analyseren van sociale media feeds

Prestatieoptimalisatie: Geef Je Streams een Turbo Boost

Wil je je streams nog sneller maken? Hier zijn enkele tips:

- Gebruik

Bufferin plaats van strings voor binaire data - Verhoog de

highWaterMarkvoor snellere doorvoer (maar wees voorzichtig met geheugengebruik) - Gebruik

Cork()enuncork()om schrijfbewerkingen te groeperen - Implementeer een aangepaste

_writev()voor efficiënter batchschrijven

Debuggen en Foutafhandeling: Wanneer Streams Fout Gaan

Streams kunnen lastig zijn om te debuggen. Hier zijn enkele strategieën:

- Gebruik de

debugmodule om streamgebeurtenissen te loggen - Behandel altijd de

'error'gebeurtenis - Gebruik

stream.finished()om te detecteren wanneer een stream klaar is of een fout heeft ondervonden

const { finished } = require('stream');

const fs = require('fs');

const rs = fs.createReadStream('file.txt');

finished(rs, (err) => {

if (err) {

console.error('Stream failed', err);

} else {

console.log('Stream is done reading');

}

});

rs.resume(); // drain the stream

Tools en Bibliotheken: Geef Je Streams een Superboost

Er zijn veel bibliotheken die het werken met streams nog eenvoudiger maken. Hier zijn er een paar die de moeite waard zijn om te bekijken:

- through2: Vereenvoudigde streamconstructie

- concat-stream: Schrijfbare stream die strings of binaire data samenvoegt

- get-stream: Verkrijg een stream als een string, buffer of array

- into-stream: Converteer een buffer/string/array/object naar een stream

Conclusie: De Kracht van de Stream

Streams in Node.js zijn als een geheim wapen in je ontwikkelaarstoolkit. Ze stellen je in staat om data efficiënt te verwerken, grote datasets met gemak te beheren en schaalbare applicaties te bouwen. Door streams te beheersen, leer je niet alleen een functie van Node.js - je neemt een krachtig paradigma voor dataverwerking over.

Onthoud, met grote kracht komt grote verantwoordelijkheid. Gebruik streams verstandig, en moge je data altijd soepel stromen!

"Ik stream, jij streamt, we streamen allemaal voor... efficiënte dataverwerking!" - Anonieme Node.js Ontwikkelaar

Ga nu op pad en stream alles! 🌊💻