Precisie is belangrijk in machine learning. Heel belangrijk. Het is het verschil tussen je AI die een kat herkent en denkt dat het een broodrooster ziet. Maar hier is de clou - soms is meer precisie niet altijd beter. Hier komt stochastische afronding om de hoek kijken.

Stochastische Afronding 101

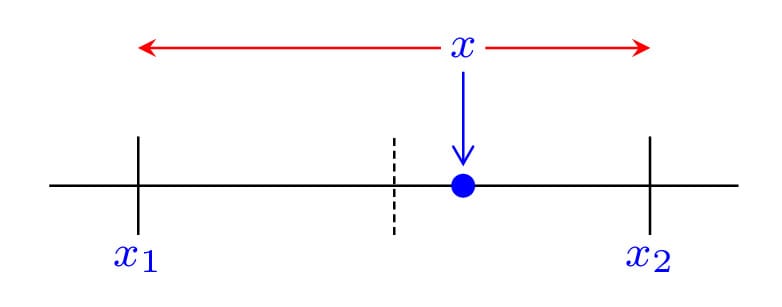

Dus, wat is deze magische techniek precies? In eenvoudige termen is stochastische afronding een methode van afronden die een beetje willekeurigheid in het proces introduceert. In plaats van altijd naar de dichtstbijzijnde waarde af te ronden, rondt het soms naar boven of naar beneden af op basis van waarschijnlijkheid.

Hier is een snel voorbeeld:

import random

def stochastic_round(x):

floor = int(x)

return floor + (random.random() < (x - floor))

# Voorbeeld gebruik

print(stochastic_round(3.7)) # Kan 3 of 4 zijn

print(stochastic_round(3.7)) # Kan 3 of 4 zijn

print(stochastic_round(3.7)) # Kan 3 of 4 zijn

Voer dit een paar keer uit, en je zult zien dat 3.7 niet altijd naar 4 wordt afgerond. Soms is het 3, soms is het 4. Het is als Schrödinger's afronding - zowel naar boven als naar beneden totdat je het observeert!

Waarom Zou Het Ons Moeten Boeien?

Nu denk je misschien, "Geweldig, we hebben willekeurigheid geïntroduceerd. Hoe helpt dit?" Nou, mijn sceptische vriend, laat me de manieren tellen:

- Verminderde Bias: Traditioneel afronden kan systematische bias introduceren, vooral bij het omgaan met veel kleine waarden. Stochastische afronding helpt dit te verminderen.

- Betere Gradiëntschattingen: In deep learning kan stochastische afronding leiden tot nauwkeurigere gradiëntschattingen tijdens backpropagation.

- Verbeterde Convergentie: Sommige studies hebben aangetoond dat stochastische afronding kan helpen neurale netwerken sneller en naar betere optima te laten convergeren.

- Hardware Efficiëntie: Het maakt het mogelijk om hardware met lagere precisie te gebruiken terwijl hoge precisie resultaten behouden blijven.

Impact in de Praktijk

Nog steeds niet overtuigd? Laten we eens kijken naar enkele concrete voorbeelden waar stochastische afronding golven maakt:

1. Training op Lagere Precisie

Onderzoekers bij Facebook AI Research (nu Meta AI) ontdekten dat het gebruik van stochastische afronding hen in staat stelde om grote taalmodellen te trainen op 8-bit precisie zonder verlies van nauwkeurigheid. Dit is enorm voor het verminderen van geheugengebruik en rekeneisen.

2. Verbeterde Kwantisatie

Google's TPU (Tensor Processing Unit) gebruikt stochastische afronding in zijn bfloat16-formaat, waardoor snellere training en inferentie mogelijk zijn zonder in te boeten op modelkwaliteit.

3. Wetenschappelijk Rekenen

Buiten ML wordt stochastische afronding gebruikt in klimaatmodellen en vloeistofdynamica-simulaties om nauwkeurigheid te behouden bij het gebruik van rekenkunde met lagere precisie.

De Schaduwzijde van Stochastische Afronding

Nu, voordat je overal stochastische afronding gaat implementeren, laten we het hebben over enkele mogelijke valkuilen:

- Reproduceerbaarheid: De willekeurigheid in stochastische afronding kan het exact reproduceren van resultaten uitdagend maken.

- Overhead: Het genereren van willekeurige getallen voor afronding kan rekentechnische overhead introduceren.

- Niet Altijd Voordelig: In sommige gevallen, vooral bij zeer diepe netwerken, kunnen de voordelen minder uitgesproken zijn.

"Met grote kracht komt grote verantwoordelijkheid" - Oom Ben (en elke datawetenschapper die stochastische afronding gebruikt)

Implementatie van Stochastische Afronding

Ben je enthousiast om het uit te proberen? Hier is een meer uitgebreide Python-implementatie waarmee je kunt spelen:

import numpy as np

def stochastic_round(x, precision=1):

scale = 10 ** precision

scaled = x * scale

floor = np.floor(scaled)

prob = scaled - floor

rounded = floor + (np.random.random(x.shape) < prob)

return rounded / scale

# Voorbeeld gebruik

x = np.array([1.34, 2.67, 3.45, 4.82])

print("Origineel:", x)

print("Stochastisch afgerond:", stochastic_round(x))

print("Numpy afronding:", np.round(x))

Voer dit een paar keer uit en vergelijk de resultaten. Je zult zien dat stochastische afronding soms verschillende resultaten geeft, terwijl numpy's afronding altijd consistent is.

De Toekomst van Precisie

Naarmate machine learning-modellen groter en complexer worden, zullen technieken zoals stochastische afronding steeds belangrijker worden. We zien al dat hardwarefabrikanten zoals NVIDIA ondersteuning voor stochastische afronding in hun nieuwste GPU's integreren.

Dus, wat is de volgende stap? Enkele gebieden om in de gaten te houden:

- Hybride Precisie Training: Het combineren van verschillende precisies en afrondmethoden voor verschillende lagen of operaties.

- Adaptieve Stochastische Afronding: Het dynamisch aanpassen van het afrondgedrag op basis van de huidige staat van de training.

- Hardwareversnelling: Meer toegewijde hardwareondersteuning voor efficiënte stochastische afrondingsoperaties.

Afronding

Stochastische afronding lijkt misschien een klein detail in het grote geheel van machine learning, maar het zijn dit soort innovaties die het veld vooruit helpen. Het stelt ons in staat om grotere modellen efficiënter te trainen, simulaties met grotere nauwkeurigheid uit te voeren en de grenzen van wat mogelijk is met beperkte hardwarebronnen te verleggen.

Dus de volgende keer dat iemand je vraagt naar de nieuwste ontwikkelingen in ML, praat dan niet alleen over transformers of reinforcement learning. Deel wat kennis over stochastische afronding en kijk hoe hun ogen oplichten van opwinding!

Stof tot Nadenken

Voordat je gaat, hier zijn enkele vragen om over na te denken:

- Hoe zou stochastische afronding de interpretatie van modellen kunnen beïnvloeden?

- Zouden stochastische afrondingstechnieken kunnen worden gebruikt om de privacy in federated learning-scenario's te verbeteren?

- Welke andere gebieden van de informatica of techniek zouden kunnen profiteren van stochastische afronding?

Onthoud, in de wereld van machine learning kan een beetje willekeurigheid soms leiden tot veel precisie. Ga nu en rond stochastisch af!