TL;DR: Wat is er nieuw in Rust 1.80 Coöperatieve Scheduling?

- Verbeterde mechanismen voor taakonderbreking

- Betere integratie met async runtimes zoals Tokio

- Verbeterde eerlijkheid in taakuitvoering

- Nieuwe API's voor fijnmazige controle over taakplanning

Het Coöperatieve Scheduling Dilemma

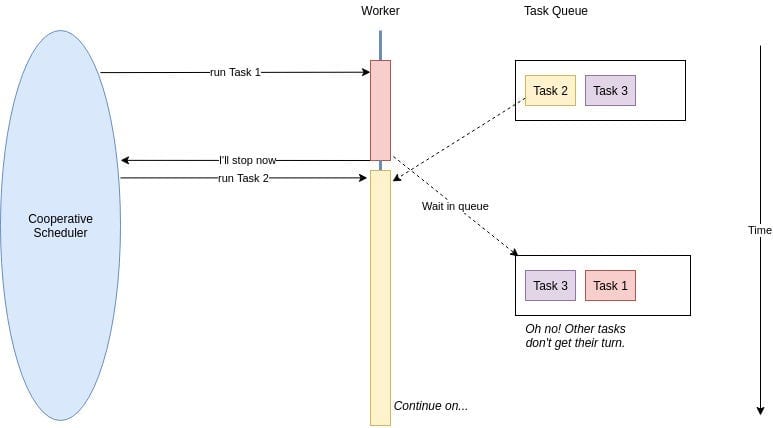

Voordat we in de details duiken, laten we ons geheugen opfrissen over wat coöperatieve scheduling inhoudt. In de async wereld van Rust werken taken samen en geven vrijwillig de controle af, zodat andere taken kunnen draaien. Het is als een groep beleefde mensen in een rij, waar iedereen anderen voor laat gaan als ze nog niet klaar zijn.

In eerdere versies van Rust leidde deze beleefdheid soms tot ongemakkelijke situaties. Langdurige taken konden de aandacht opeisen, waardoor andere belangrijke operaties moesten wachten. Rust 1.80 komt hier met oplossingen om deze dans soepeler te maken.

De Nieuwe Spelers: Verbeterde Onderbrekingsmechanismen

Rust 1.80 introduceert geavanceerdere onderbrekingsmechanismen die taken in staat stellen om betere buren te zijn. Hier is een kort overzicht van hoe je deze nieuwe functies kunt gebruiken:

use std::future::Future;

use std::pin::Pin;

use std::task::{Context, Poll};

struct YieldingTask {

yielded: bool,

}

impl Future for YieldingTask {

type Output = ();

fn poll(mut self: Pin<&mut Self>, cx: &mut Context<'_>) -> Poll {

if !self.yielded {

self.yielded = true;

cx.waker().wake_by_ref();

Poll::Pending

} else {

Poll::Ready(())

}

}

}

Dit voorbeeld toont een taak die één keer onderbreekt voordat hij voltooit. De nieuwe wake_by_ref() methode is efficiënter en vermijdt onnodige klonen van de Waker.

Tokio en Rust 1.80: Een Perfecte Combinatie in Async Hemel

Als je Tokio gebruikt (en wie doet dat niet?), dan staat je iets moois te wachten. De verbeteringen in Rust 1.80 sluiten perfect aan bij Tokio's runtime. Hier is hoe je van deze synergie kunt profiteren:

use tokio::time::{sleep, Duration};

#[tokio::main]

async fn main() {

let task1 = tokio::spawn(async {

for i in 1..=5 {

println!("Taak 1: {}", i);

sleep(Duration::from_millis(100)).await;

}

});

let task2 = tokio::spawn(async {

for i in 1..=5 {

println!("Taak 2: {}", i);

sleep(Duration::from_millis(100)).await;

}

});

let _ = tokio::join!(task1, task2);

}

Dit voorbeeld laat zien hoe Tokio's runtime nu nog beter samenwerkt met Rust 1.80's coöperatieve scheduling, wat zorgt voor eerlijke uitvoering tussen taken.

Eerlijkheid: Niet Alleen voor Speelplaatsconflicten

Een van de opvallende kenmerken in Rust 1.80 is de verbeterde eerlijkheid in taakuitvoering. Geen taakpesters meer die alle CPU-tijd opeisen! De runtime verdeelt nu de middelen beter over de taken, wat cruciaal is voor microservices onder zware belasting.

Overweeg dit scenario:

use tokio::time::{sleep, Duration};

use std::sync::Arc;

use std::sync::atomic::{AtomicUsize, Ordering};

#[tokio::main]

async fn main() {

let counter = Arc::new(AtomicUsize::new(0));

let tasks: Vec<_> = (0..100).map(|i| {

let counter = Arc::clone(&counter);

tokio::spawn(async move {

loop {

counter.fetch_add(1, Ordering::SeqCst);

if i % 10 == 0 {

sleep(Duration::from_millis(1)).await;

}

}

})

}).collect();

sleep(Duration::from_secs(5)).await;

for task in tasks {

task.abort();

}

println!("Totaal aantal verhogingen: {}", counter.load(Ordering::SeqCst));

}

In dit voorbeeld maken we 100 taken aan, die elk een gedeelde teller verhogen. Sommige taken (elke 10e) slapen kort, wat I/O-operaties simuleert. Met de verbeterde eerlijkheid van Rust 1.80 zul je een meer gebalanceerde verdeling van verhogingen over de taken opmerken, zelfs onder deze kunstmatige belasting.

Fijnmazige Controle: Jouw Nieuwe Superkracht

Rust 1.80 geeft je meer controle over taakplanning met nieuwe API's. Het is als een toverstokje voor je async code. Hier is een voorproefje van wat je kunt doen:

use std::future::Future;

use std::pin::Pin;

use std::task::{Context, Poll};

struct ControlledYield {

yields_left: usize,

}

impl Future for ControlledYield {

type Output = ();

fn poll(mut self: Pin<&mut Self>, cx: &mut Context<'_>) -> Poll {

if self.yields_left > 0 {

self.yields_left -= 1;

cx.waker().wake_by_ref();

Poll::Pending

} else {

Poll::Ready(())

}

}

}

async fn controlled_task(yields: usize) {

ControlledYield { yields_left: yields }.await;

println!("Taak voltooid na {} onderbrekingen", yields);

}

Deze ControlledYield future stelt je in staat om precies aan te geven hoe vaak een taak moet onderbreken voordat hij voltooit. Het is als een precieze controleknop voor het coöperatieve gedrag van elke taak.

De Valkuilen: Kijk Uit!

Hoewel de verbeteringen in coöperatieve scheduling van Rust 1.80 fantastisch zijn, zijn ze geen wondermiddel. Hier zijn enkele valkuilen om op te letten:

- Te veel onderbrekingen kunnen leiden tot onnodige contextwisselingen en verminderde prestaties.

- Te weinig onderbrekingen in CPU-intensieve taken kunnen nog steeds latentiepieken veroorzaken.

- Te veel vertrouwen op de eerlijkheid van de runtime kan onderliggende ontwerpproblemen in je microservices-architectuur maskeren.

Alles Samenvoegen: Een Realistische Scenario

Laten we kijken naar een realistischer voorbeeld van hoe deze verbeteringen kunnen worden toegepast in een microservice onder zware belasting:

use tokio::time::{sleep, Duration};

use std::sync::Arc;

use tokio::sync::Semaphore;

async fn process_request(id: u32, semaphore: Arc) {

let _permit = semaphore.acquire().await.unwrap();

println!("Verwerken van verzoek {}", id);

// Simuleer wat werk

sleep(Duration::from_millis(100)).await;

println!("Verzoek voltooid {}", id);

}

#[tokio::main]

async fn main() {

let semaphore = Arc::new(Semaphore::new(10)); // Beperk gelijktijdige verwerking

let mut handles = vec![];

for i in 0..1000 {

let sem = Arc::clone(&semaphore);

handles.push(tokio::spawn(async move {

process_request(i, sem).await;

}));

}

for handle in handles {

handle.await.unwrap();

}

}

In dit voorbeeld simuleren we een microservice die 1000 verzoeken gelijktijdig verwerkt, maar de daadwerkelijke gelijktijdige verwerking beperkt tot 10 tegelijk met behulp van een semafoor. De verbeterde coöperatieve scheduling van Rust 1.80 zorgt ervoor dat zelfs onder deze zware belasting elke taak een eerlijke kans krijgt op uitvoering, waardoor wordt voorkomen dat een enkel verzoek alle middelen monopoliseert.

De Conclusie: Omarm de Coöperatieve Geest

De verbeteringen in coöperatieve scheduling van Rust 1.80 zijn een game-changer voor microservices die onder zware belasting opereren. Door gebruik te maken van deze verbeteringen kun je:

- Latentiepieken verminderen door eerlijke taakuitvoering te garanderen

- De algehele systeemresponsiviteit verbeteren

- Je async code fijn afstemmen voor optimale prestaties

- Meer veerkrachtige microservices bouwen die verkeerspieken gracieus kunnen verwerken

Onthoud, de sleutel tot het beheersen van deze nieuwe functies is oefening en experimentatie. Wees niet bang om erin te duiken en te zien hoe ze je microservices-architectuur kunnen transformeren.

Stof tot Nadenken

"In de wereld van microservices is samenwerking niet alleen leuk om te hebben—het is essentieel voor overleving."

Terwijl je deze nieuwe coöperatieve schedulingpatronen implementeert, vraag jezelf af:

- Hoe kan ik knelpunten identificeren in mijn huidige microservices die baat kunnen hebben bij verbeterde scheduling?

- Welke statistieken moet ik monitoren om ervoor te zorgen dat ik het meeste uit deze nieuwe functies haal?

- Hoe kan ik mijn team informeren over deze verbeteringen en best practices in async Rust-ontwikkeling aanmoedigen?

Door deze vragen continu te stellen en de mogelijkheden van Rust 1.80 te verkennen, ben je goed op weg om microservices te bouwen die niet alleen overleven onder druk—ze floreren.

Ga nu op pad en werk samen als nooit tevoren! Je microservices (en je gebruikers) zullen je dankbaar zijn.