JSON-parsing is niet bepaald het meest glamoureuze deel van ons werk. Maar als je dagelijks met terabytes aan loggegevens werkt, telt elke milliseconde. Hier komt GPU-versnelling om de hoek kijken, met de belofte om je parsing-pijplijn te transformeren van een trage luiaard in een cheeta op steroïden.

De Uitdagers Betreden de Arena

In de blauwe hoek, met bliksemsnelle snelheden en CPU-optimalisatie, hebben we simdjson. En in de rode hoek, met CUDA-kernen die klaar zijn voor actie, hebben we onze GPU-gebaseerde parsers. Laten we de kandidaten eens nader bekijken:

- simdjson: De heersende CPU-kampioen, bekend om zijn SIMD-aangedreven parsingkracht

- RAPIDS cuDF: NVIDIA's uitdager, die GPU-versnelling naar de data frame-feest brengt

- Bigstream: Een outsider in de race, die GPU-versnelde gegevensverwerking biedt

Benchmark Setup: Geen Rook en Spiegels

Voordat we naar de resultaten duiken, laten we de basis leggen voor onze benchmark. We vergelijken hier niet alleen de ruwe parsingsnelheden; we kijken naar het hele plaatje, inclusief:

- PCIe-overdrachtskosten (want wat naar de GPU gaat, moet ook weer terugkomen)

- CUDA-kernel opstartvertraging

- Geheugenallocatie- en deallocatietijden

- Werkelijke parsingprestaties

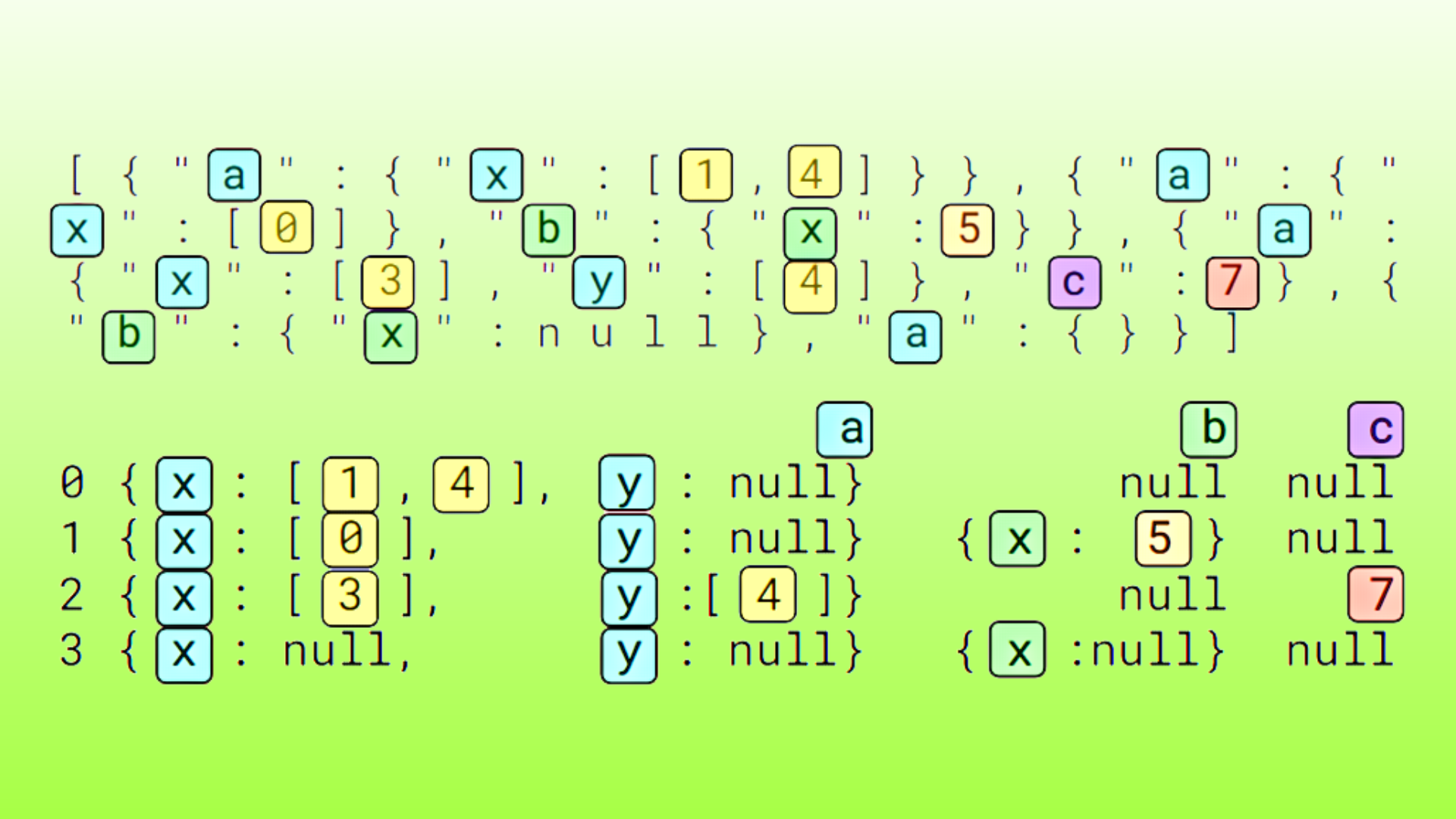

Onze testdataset? Een forse 10GB JSON-bestand gevuld met typische logvermeldingen. Denk aan tijdstempels, ernstniveaus, bron-IP's en genoeg geneste objecten om je hoofd te laten tollen.

De Hardware

We draaien deze wedstrijd op een krachtige machine:

- CPU: AMD Ryzen 9 5950X (16 cores, 32 threads)

- GPU: NVIDIA GeForce RTX 3090 (24GB GDDR6X)

- RAM: 64GB DDR4-3600

- Opslag: NVMe SSD met 7000MB/s leessnelheden (want we zijn hier niet om naar laadschermen te kijken)

Ronde 1: Ruwe Parsingsnelheid

Laten we eerst kijken naar de ruwe parsingsnelheden, waarbij we de overdrachtskosten voorlopig negeren:

import matplotlib.pyplot as plt

parsers = ['simdjson', 'RAPIDS cuDF', 'Bigstream']

parsing_speeds = [5.2, 12.8, 10.5] # GB/s

plt.bar(parsers, parsing_speeds)

plt.title('Ruwe JSON Parsingsnelheid')

plt.ylabel('Snelheid (GB/s)')

plt.show()

Wauw! De GPU-parsers laten simdjson ver achter zich, met RAPIDS cuDF aan kop met een verbluffende 12.8 GB/s. Maar voordat we een kampioen kronen, laten we de vervelende PCIe-overdrachten niet vergeten.

De PCIe-flessenhals: Realiteitscheck

Hier wordt het interessant. Vergeet niet dat we die gegevens naar de GPU en terug moeten verplaatsen. PCIe 4.0 x16 geeft ons een theoretische bandbreedte van 64 GB/s, maar de prestaties in de echte wereld zijn meer als 50 GB/s. Laten we eens kijken hoe dit onze resultaten beïnvloedt:

pcie_transfer_speed = 50 # GB/s

effective_speeds = [

5.2, # simdjson (CPU, geen overdracht nodig)

1 / (1/12.8 + 2/pcie_transfer_speed), # RAPIDS cuDF

1 / (1/10.5 + 2/pcie_transfer_speed) # Bigstream

]

plt.bar(parsers, effective_speeds)

plt.title('Effectieve Parsingsnelheid (inclusief PCIe-overdracht)')

plt.ylabel('Snelheid (GB/s)')

plt.show()

Oei! Onze GPU-snelheidsduivels stuiten op de PCIe-muur. De effectieve snelheden zijn nu:

- simdjson: 5.2 GB/s

- RAPIDS cuDF: 10.2 GB/s

- Bigstream: 8.9 GB/s

Nog steeds sneller dan simdjson, maar niet met de marge die we aanvankelijk zagen. Dit is waarom je altijd de kleine lettertjes moet lezen!

CUDA Kernel Optimalisatie: Het Geheime Ingrediënt

Nu we onze realiteitscheck hebben gehad, laten we het hebben over hoe we meer prestaties uit onze GPU-parsers kunnen halen. De sleutel? Geheugencoalescentie en slimme werkverdeling.

Geheugencoalescentie: Maak Elke Geheugentoegang Telt

CUDA-kernels houden ervan als je geheugen op een nette, ordelijke manier benadert. Hier is een eenvoudig voorbeeld van hoe we onze JSON-parsingkernel kunnen structureren voor betere geheugencoalescentie:

__global__ void parseJSONKernel(const char* input, int* output, int inputSize) {

int tid = blockIdx.x * blockDim.x + threadIdx.x;

int stride = blockDim.x * gridDim.x;

for (int i = tid; i < inputSize; i += stride) {

// Verwerk 128-byte blokken voor betere geheugentoegangspatronen

char chunk[128];

for (int j = 0; j < 128 && i + j < inputSize; j++) {

chunk[j] = input[i + j];

}

// Parse het blok en schrijf resultaten naar output

// ...

}

}

Door gegevens in blokken te verwerken en uitgelijnde geheugentoegangen te garanderen, kunnen we onze parsingsnelheid aanzienlijk verbeteren.

Werkverdeling: Load Balancing voor de Winst

Niet alle JSON-objecten zijn gelijk. Sommige zijn eenvoudige sleutel-waardeparen, terwijl andere geneste monsters zijn die Cthulhu trots zouden maken. Om de werklast over onze GPU-kernen te balanceren, kunnen we een tweepassige aanpak implementeren:

- Eerste pass: Scan de invoer om objectgrenzen en complexiteit te identificeren

- Tweede pass: Verdeel parsingwerk op basis van de complexiteitskaart van de eerste pass

Dit zorgt ervoor dat al onze CUDA-kernen even hard werken, in plaats van dat sommige vroeg klaar zijn terwijl anderen worstelen met complexe objecten.

De Resultaten: Tromgeroffel, Alsjeblieft...

Na het implementeren van deze optimalisaties, laten we eens kijken naar onze uiteindelijke benchmarkresultaten:

optimized_speeds = [5.2, 11.5, 10.1] # GB/s

plt.bar(parsers, optimized_speeds)

plt.title('Geoptimaliseerde Parsingsnelheid (inclusief PCIe-overdracht)')

plt.ylabel('Snelheid (GB/s)')

plt.show()

De eindstand:

- RAPIDS cuDF: 11.5 GB/s

- Bigstream: 10.1 GB/s

- simdjson: 5.2 GB/s

Onze GPU-parsers liggen nu comfortabel voor, zelfs met de PCIe-kosten meegerekend. Maar wat betekent dit voor logverwerkingspijplijnen in de echte wereld?

Praktische Implicaties: Je Logverwerking Versnellen

Laten we deze cijfers in perspectief plaatsen. Stel dat een typische logverwerkingspijplijn dagelijks 1TB aan JSON-logs verwerkt:

- simdjson: ~53 uur

- Geoptimaliseerde RAPIDS cuDF: ~24 uur

Dat is bijna de helft van je verwerkingstijd! Maar voordat je je hele pijplijn in CUDA herschrijft, overweeg deze punten:

Wanneer te Kiezen voor GPU

- Grootschalige logverwerking (denk aan 100GB+ dagelijks)

- Realtime analyses die snelle JSON-parsing vereisen

- Batchverwerkingsopdrachten met strakke tijdsbeperkingen

Wanneer te Blijven bij CPU

- Kleinere logvolumes waar CPU-prestaties voldoende zijn

- Omgevingen zonder beschikbare GPU-hardware

- Wanneer eenvoud en onderhoudsgemak prioriteit hebben

Conclusie: GPU of Niet GPU?

GPU-versnelde JSON-parsing is niet zomaar een trucje—het is een game-changer voor logverwerkingspijplijnen met een hoog volume. Hoewel de PCIe-overdrachtskosten wat van de glans van de ruwe prestatienummers wegnemen, bieden de geoptimaliseerde GPU-parsers nog steeds een aanzienlijke versnelling ten opzichte van CPU-gebaseerde oplossingen zoals simdjson.

Het is echter geen oplossing die voor iedereen geschikt is. De beslissing om je JSON-parsing te GPU-ificeren moet gebaseerd zijn op je specifieke gebruikssituatie, datavolumes en prestatie-eisen. En onthoud, met grote kracht komt grote verantwoordelijkheid—en elektriciteitsrekeningen. Zorg ervoor dat de prestatieverbetering de extra complexiteit en middelengebruik rechtvaardigt.

Belangrijkste Leerpunten

- GPU-parsing kan 2-3x sneller zijn dan geoptimaliseerde CPU-parsing

- PCIe-overdrachtskosten zijn aanzienlijk en moeten in prestatieberekeningen worden meegenomen

- Goede CUDA-kerneloptimalisatie is cruciaal voor het maximaliseren van GPU-prestaties

- Overweeg je gebruikssituatie zorgvuldig voordat je de overstap naar GPU-parsing maakt

Dus daar heb je het—een diepgaande blik in de wereld van GPU-versnelde JSON-parsing. Of je nu team CPU of team GPU bent, één ding is zeker: de toekomst van logverwerking ziet er sneller uit dan ooit. Nu, als je me wilt excuseren, ik heb een afspraak met een paar miljoen logvermeldingen en een glanzende RTX 3090.

"JSON parsen zonder een GPU is als een mes meenemen naar een vuurgevecht. Soms werkt het, maar zou je niet liever een bazooka hebben?" - Anonieme Data Engineer, waarschijnlijk

Veel plezier met parsen, en moge je logs altijd gestructureerd zijn en je pijplijnen altijd vloeiend!