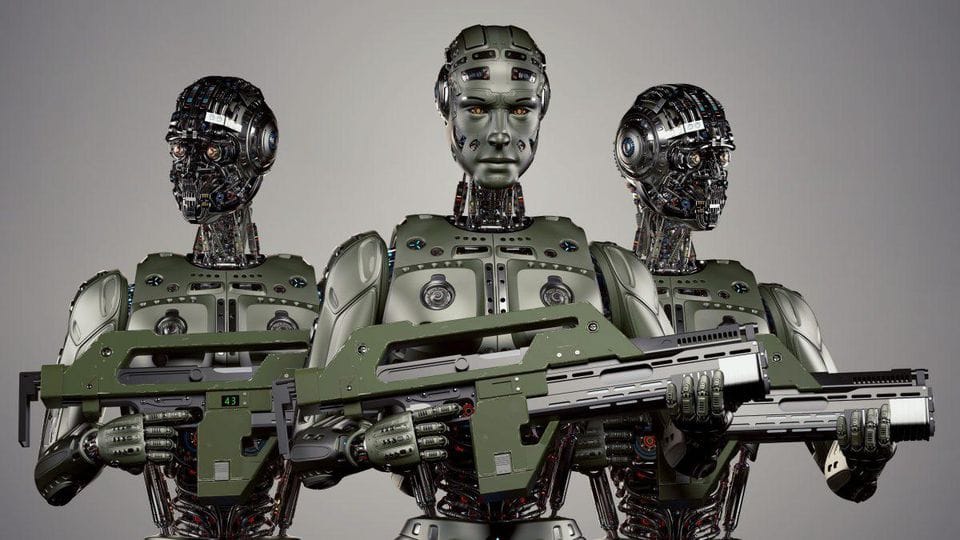

Autonome wapensystemen zijn militaire platforms die doelen kunnen selecteren en aanvallen zonder menselijke tussenkomst. Zie ze als de dodelijke neven van zelfrijdende auto's. In plaats van verkeer te navigeren, navigeren ze slagvelden. En in plaats van botsingen te vermijden, nou ja, je snapt het idee.

Deze systemen kunnen variëren van:

- Autonome drones die vijandelijke posities kunnen identificeren en aanvallen

- AI-gestuurde raketsystemen die hun traject tijdens de vlucht kunnen aanpassen

- Robotische wachters die grenzen of gevoelige installaties bewaken

Het belangrijkste kenmerk hier is autonomie. In tegenstelling tot op afstand bestuurde wapens, nemen AWS hun eigen beslissingen op basis van vooraf geprogrammeerde parameters en realtime data-analyse.

Het Ethische Mijnenveld

Nu we de basis hebben behandeld, laten we ons verdiepen in het ethische moeras. De ontwikkeling en inzet van AWS roept een reeks morele vragen op die zelfs de meest doorgewinterde filosoof aan het denken zouden zetten.

1. De Verantwoordelijkheidskloof

Wie is er verantwoordelijk als een autonoom wapen een fout maakt? De programmeur die het algoritme schreef? De militaire commandant die het inzette? De AI zelf? Deze "verantwoordelijkheidskloof" is een belangrijk struikelblok in het ethische debat.

"Met grote macht komt grote verantwoordelijkheid" - Oom Ben, Spider-Man

Maar wat gebeurt er als die macht wordt uitgeoefend door een AI die het concept van verantwoordelijkheid niet begrijpt?

2. De Verlaagde Drempel voor Gewapend Conflict

Als oorlogen kunnen worden uitgevochten met robots in plaats van menselijke soldaten, maakt dat militaire actie dan aantrekkelijker? Er is bezorgdheid dat AWS de drempel voor gewapend conflict kan verlagen, waardoor oorlog vaker voorkomt.

3. Gebrek aan Menselijk Oordeel

Mensen kunnen rekening houden met context, nuances en last-minute veranderingen die een beslissing om dodelijk geweld te gebruiken kunnen beïnvloeden. Kunnen we echt vertrouwen op een AI om deze levens- of doodsbeslissingen te nemen?

4. Potentieel voor Misbruik

In verkeerde handen kunnen AWS worden gebruikt voor onderdrukking, terrorisme of andere duistere doeleinden. De democratisering van geavanceerde militaire technologie is een tweesnijdend zwaard.

Huidige Regelgevende Landschap

Dus, kan AI worden gereguleerd in oorlogsvoering? Het korte antwoord is: we proberen het, maar het is ingewikkeld.

Momenteel is er geen internationaal verdrag dat specifiek AWS reguleert. Er zijn echter verschillende initiatieven gaande:

- De Conventie over Bepaalde Conventionele Wapens (CCW) bespreekt AWS sinds 2014

- De Campagne om Killer Robots te Stoppen pleit voor een preventief verbod op volledig autonome wapens

- Sommige landen, zoals België en Luxemburg, hebben AWS al verboden in hun militaire doctrines

De uitdaging ligt in het creëren van regelgeving die specifiek genoeg is om effectief te zijn, maar flexibel genoeg om rekening te houden met snelle technologische vooruitgang.

Potentiële Regelgevende Benaderingen

Laten we enkele potentiële manieren verkennen om AI in oorlogsvoering te reguleren:

1. Internationaal Verdrag

Een uitgebreid internationaal verdrag zou duidelijke richtlijnen kunnen stellen voor de ontwikkeling en het gebruik van AWS. Dit zou kunnen omvatten:

- Definities van wat een autonoom wapen is

- Regels voor inzet van AWS

- Verantwoordelijkheidsmechanismen voor wanneer dingen misgaan

2. "Mens in de Lus" Vereiste

Het verplichten van menselijk toezicht in alle AWS-operaties zou kunnen helpen om enkele ethische zorgen aan te pakken. Dit kan op verschillende niveaus worden geïmplementeerd:

def autonomous_weapon_system(target):

if human_approval():

engage_target(target)

else:

stand_down()

def human_approval():

# Deze functie zou vereisen dat een menselijke operator de actie goedkeurt

return input("Doelwit goedkeuren? (j/n): ") == 'j'

3. Ethisch AI Ontwerp

Het integreren van ethische overwegingen in de kern van AI-systemen kan helpen om enkele risico's te verminderen. Dit kan inhouden:

- Het programmeren van de wetten van oorlog en regels van inzet

- Het implementeren van robuuste noodstop- en afbreekmechanismen

- Het ontwerpen van systemen met transparantie en controleerbaarheid in gedachten

4. Internationale Toezichtsinstantie

Een onafhankelijke internationale instantie zou kunnen worden opgericht om toezicht te houden op de ontwikkeling en inzet van AWS, vergelijkbaar met de rol van het Internationaal Atoomenergieagentschap in nucleaire non-proliferatie.

De Weg Vooruit

Het reguleren van AI in oorlogsvoering is een Herculeaanse taak, maar het is er een die we niet kunnen negeren. Terwijl technologie in een razend tempo blijft vooruitgaan, moeten onze ethische en regelgevende kaders gelijke tred houden.

Hier zijn enkele belangrijke overwegingen voor de toekomst:

- Interdisciplinaire samenwerking: We hebben ethici, technologen, beleidsmakers en militaire experts nodig die samenwerken om effectieve regelgeving te ontwikkelen.

- Transparantie: Landen die AWS ontwikkelen, moeten transparant zijn over hun capaciteiten en bedoelingen.

- Voortdurende dialoog: Naarmate technologie evolueert, moet ook onze benadering van regulering evolueren. Regelmatige internationale discussies zijn cruciaal.

- Publieke bewustwording: De implicaties van AWS zouden niet alleen een zorg moeten zijn voor experts. Publiek begrip en input zijn van vitaal belang.

Stof tot Nadenken

Terwijl we deze diepgaande verkenning van de ethiek van autonome wapens afsluiten, zijn hier enkele vragen om over na te denken:

- Is het mogelijk om een AI-systeem te creëren dat ethische beslissingen in oorlogsvoering beter kan maken dan mensen?

- Hoe balanceren we de potentiële voordelen van AWS (zoals het verminderen van menselijke slachtoffers) met de ethische risico's?

- Zou de ontwikkeling van AWS kunnen leiden tot een AI-wapenwedloop? Zo ja, hoe voorkomen we dat?

Het debat over autonome wapensystemen is nog lang niet voorbij. Als technologen is het cruciaal dat we ons bezighouden met deze ethische vragen. Tenslotte, de code die we vandaag schrijven, kan de slagvelden van morgen vormgeven.

"Het echte probleem is niet of machines denken, maar of mensen dat doen." - B.F. Skinner

Laten we ervoor zorgen dat we diep nadenken over de implicaties van ons werk. De toekomst van oorlogsvoering - en mogelijk de mensheid zelf - kan ervan afhangen.