TL;DR: Rust + Async = Job Queue op Steroïden

De async runtime van Rust is als een espresso met raketbrandstof voor je job queue. Het maakt gelijktijdige uitvoering van taken mogelijk zonder de overhead van OS-niveau threads, wat het perfect maakt voor I/O-gebonden operaties zoals het beheren van een job queue. Laten we eens kijken hoe we dit kunnen gebruiken om een backend te creëren die je taken sneller laat vliegen dan een cafeïnehoudende cheetah.

De Bouwstenen: Tokio, Futures en Channels

Voordat we beginnen met het bouwen van onze high-performance job queue, laten we kennismaken met de belangrijkste onderdelen:

- Tokio: Het Zwitserse zakmes... eh, ik bedoel, de veelzijdige async runtime voor Rust

- Futures: Representaties van asynchrone berekeningen

- Channels: Communicatiekanalen tussen verschillende delen van je async systeem

Deze componenten werken samen als een goed geoliede machine, waardoor we een job queue kunnen bouwen die een indrukwekkende doorvoer aankan zonder te zweten.

Het Ontwerpen van de Job Queue: Een Vogelperspectief

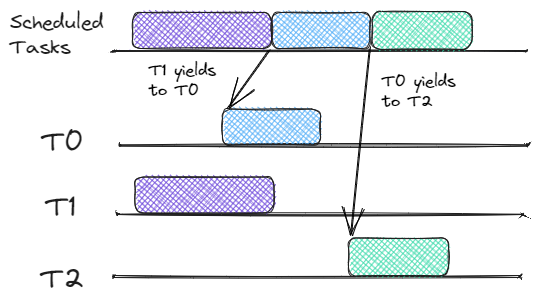

Onze job queue zal bestaan uit drie hoofdcomponenten:

- Job Ontvanger: Accepteert binnenkomende jobs en plaatst ze in de queue

- Job Queue: Slaat jobs op die wachten om verwerkt te worden

- Job Verwerker: Haalt jobs uit de queue en voert ze uit

Laten we eens kijken hoe we dit kunnen implementeren met de async mogelijkheden van Rust.

De Job Ontvanger: De Portier van je Queue

Laten we eerst een struct maken om onze jobs te vertegenwoordigen:

struct Job {

id: u64,

payload: String,

}

Nu implementeren we de job ontvanger:

use tokio::sync::mpsc;

async fn job_receiver(mut rx: mpsc::Receiver, queue: Arc>>) {

while let Some(job) = rx.recv().await {

let mut queue = queue.lock().await;

queue.push_back(job);

println!("Ontvangen job: {}", job.id);

}

}

Deze functie gebruikt Tokio's MPSC (Multi-Producer, Single-Consumer) kanaal om jobs te ontvangen en ze in een gedeelde queue te plaatsen.

De Job Queue: Waar Taken Wachten

Onze job queue is een eenvoudige VecDeque verpakt in een Arc> voor veilige gelijktijdige toegang:

use std::collections::VecDeque;

use std::sync::Arc;

use tokio::sync::Mutex;

let queue: Arc>> = Arc::new(Mutex::new(VecDeque::new()));

De Job Verwerker: Waar de Magie Gebeurt

Nu voor het pièce de résistance, onze job verwerker:

async fn job_processor(queue: Arc>>) {

loop {

let job = {

let mut queue = queue.lock().await;

queue.pop_front()

};

if let Some(job) = job {

println!("Verwerken job: {}", job.id);

// Simuleer wat async werk

tokio::time::sleep(Duration::from_millis(100)).await;

println!("Voltooide job: {}", job.id);

} else {

// Geen jobs, laten we even pauzeren

tokio::time::sleep(Duration::from_millis(10)).await;

}

}

}

Deze verwerker draait in een oneindige lus, controleert op jobs en verwerkt ze asynchroon. Als er geen jobs zijn, neemt hij een korte pauze om onnodig draaien te voorkomen.

Alles Samenbrengen: Het Hoofdgebeuren

Nu gaan we alles samenvoegen in onze hoofdfunctie:

#[tokio::main]

async fn main() {

let (tx, rx) = mpsc::channel(100);

let queue = Arc::new(Mutex::new(VecDeque::new()));

// Start de job ontvanger

let queue_clone = Arc::clone(&queue);

tokio::spawn(async move {

job_receiver(rx, queue_clone).await;

});

// Start meerdere job verwerkers

for _ in 0..4 {

let queue_clone = Arc::clone(&queue);

tokio::spawn(async move {

job_processor(queue_clone).await;

});

}

// Genereer enkele jobs

for i in 0..1000 {

let job = Job {

id: i,

payload: format!("Job {}", i),

};

tx.send(job).await.unwrap();

}

// Wacht tot alle jobs zijn verwerkt

tokio::time::sleep(Duration::from_secs(10)).await;

}

Prestatieverhogers: Tips en Trucs

Nu we onze basisstructuur hebben, laten we eens kijken naar enkele manieren om nog meer prestaties uit onze job queue te halen:

- Batchverwerking: Verwerk meerdere jobs in een enkele async taak om overhead te verminderen.

- Prioritering: Implementeer een prioriteitsqueue in plaats van een eenvoudige FIFO.

- Terugdruk: Gebruik begrensde kanalen om te voorkomen dat het systeem overbelast raakt.

- Metingen: Implementeer tracking om de queue-grootte, verwerkingstijd en doorvoer te monitoren.

Potentiële Valkuilen: Kijk Uit!

Zoals bij elk high-performance systeem, zijn er enkele dingen om op te letten:

- Deadlocks: Wees voorzichtig met de volgorde van locks bij het gebruik van meerdere mutexen.

- Uitputting van Middelen: Zorg ervoor dat je systeem het maximale aantal gelijktijdige taken aankan.

- Foutafhandeling: Implementeer robuuste foutafhandeling om te voorkomen dat taakfouten het hele systeem laten crashen.

Conclusie: Je Queue, Supercharged

Door gebruik te maken van Rust's async runtime, hebben we een job queue backend gecreëerd die een enorme doorvoer aankan met minimale overhead. De combinatie van Tokio, futures en kanalen stelt ons in staat om taken gelijktijdig en efficiënt te verwerken, waardoor we het meeste uit onze systeembronnen halen.

Onthoud, dit is slechts een beginpunt. Je kunt dit systeem verder optimaliseren en aanpassen aan je specifieke behoeften. Misschien wat persistentie toevoegen, retries voor mislukte jobs implementeren, of zelfs de queue over meerdere nodes verdelen. De mogelijkheden zijn eindeloos!

"Met grote kracht komt grote verantwoordelijkheid" - Oom Ben (en elke Rust programmeur ooit)

Dus ga aan de slag, benut de kracht van Rust's async runtime, en bouw job queues die zelfs de meest veeleisende systemen tevreden laten spinnen. Je toekomstige zelf (en je gebruikers) zullen je dankbaar zijn!

Stof tot Nadenken

Voordat je je hele backend in Rust herschrijft, neem even de tijd om te overwegen:

- Hoe zou dit zich verhouden tot het implementeren van een vergelijkbaar systeem in Go of Node.js?

- Welke soorten workloads zouden het meest profiteren van deze architectuur?

- Hoe zou je persistentie en fouttolerantie in een productieomgeving aanpakken?

Veel programmeerplezier, en moge je queues altijd snel zijn en je taken altijd voltooid!